在电商平台与社交媒体日益发展的今天,产品评论已成为洞察用户心声、评估市场反馈的宝贵数据源。本文将以华为MatePad 11的用户评论为例,详细介绍如何利用SnowNLP模型进行情感分析的数据处理全流程,为后续深入的情感倾向分析奠定坚实基础。

一、 数据采集与初步观察

数据处理的第一步是获取原始评论数据。通常,数据可以通过以下途径获得:

- 公开电商平台:如京东、天猫、华为官方商城等,利用Python爬虫工具(如Requests、BeautifulSoup、Selenium)爬取MatePad 11产品下的用户评价文本、评分、购买时间等信息。

- 社交媒体与论坛:如微博、知乎、贴吧中相关的讨论帖文。

采集到的原始数据通常是非结构化的文本,可能包含大量无关信息,如广告、重复内容、纯符号等。因此,首先需要对数据进行初步观察,了解数据的基本情况,如评论数量、评分分布、文本长度等。

二、 数据清洗与预处理

这是数据处理的核心环节,旨在将原始文本转化为高质量、规整的分析语料。主要步骤包括:

- 去重与无关信息剔除:删除完全重复的评论,并过滤掉与产品体验无关的评论(例如仅提及物流、客服,而未涉及产品本身性能、屏幕、续航、手写笔等核心特性的评论)。

- 文本规范化:

- 去除特殊字符与HTML标签:清除爬虫可能携带的HTML标签、URL链接、@用户名等。

- 繁简转换:确保所有文本为简体中文,可使用

zhconv等库进行转换。

- 纠正常见错别字:针对中文评论中常见的拼音或音近错别字进行初步校正(例如,“狠”好 -> “很”好),可建立常见错误映射表进行处理。

- 中文分词:SnowNLP本身具备分词功能,但为了提高后续情感分析的准确性,也可以考虑使用更专业的分词工具(如Jieba)进行预分词,并可能导入自定义词典,加入“MatePad”、“120Hz高刷”、“鸿蒙OS”、“M-Pencil”等产品相关专有名词,确保其不被错误切分。

- 去除停用词:加载中文停用词表,剔除“的”、“了”、“和”、“在”等对情感分析贡献极小的虚词和常见高频词,以降低数据噪声。

三、 数据标注与情感标签生成(可选但推荐)

SnowNLP内置的情感分析模型基于已标注的在线评论数据训练而成,其默认输出是一个介于0到1之间的情感值(越接近1表示情感越积极)。为了更贴合消费电子产品评论这一垂直领域,或者为了验证模型在本数据集上的效果,可以进行人工标注。

- 标注策略:随机抽取一部分清洗后的评论(如500-1000条),由人工根据文本内容判断情感倾向,分为“积极”、“消极”、“中性”三类。例如,提及“屏幕清晰”、“续航给力”、“系统流畅”的标注为积极;提及“发热严重”、“有残影”、“配件贵”的标注为消极;仅陈述事实如“昨天刚收到货”则标注为中性。

- 生成情感值:对于未标注的绝大部分数据,则直接使用SnowNLP模型计算其情感分值(sentiment score)。

from snownlp import SnowNLP; s = SnowNLP(comment_text); score = s.sentiments。 - 结果离散化(根据分析需求):为了进行情感分布统计,通常会将连续的情感分值转换为类别标签。常见的划分方式是:

score > 0.6为“积极”,score < 0.4为“消极”,介于两者之间为“中性”。这个阈值可以根据人工标注样本的分布情况进行调整优化。

四、 特征工程与数据集构建

为了进行更深入的分析(如情感原因挖掘),可以从清洗后的文本中构建特征。

- 关键属性提取:利用关键词匹配或简单的规则,识别评论中提及的产品特性,如“屏幕/显示”、“续航/电池”、“性能/速度”、“音效”、“手写笔”、“外观/材质”、“系统/软件”等,并为每条评论打上相应的属性标签。这有助于后续分析不同维度的用户满意度。

- 构建分析数据集:将处理后的数据整合为一个结构化的数据集(如Pandas DataFrame),每一行代表一条评论,包含的字段可以有:

清洗后文本、原始评分、SnowNLP情感分值、情感类别(积极/消极/中性)、提及的属性列表、评论日期等。

五、 数据质量评估与保存

在进入正式分析前,应对处理后的数据进行抽样检查,评估清洗和标注的质量。确认无误后,将最终的数据集保存为CSV或JSON格式,以便后续加载至分析阶段。

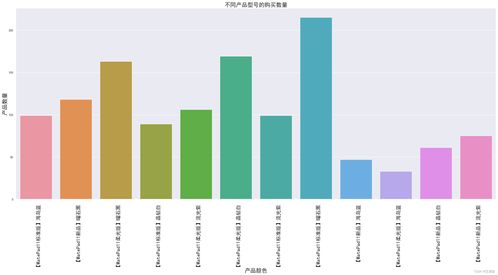

通过以上五个步骤的系统化数据处理,我们得到了一份干净、规整、富含信息量的MatePad 11用户评论数据集。这份数据不仅可以直接用于情感分布的可视化(如绘制积极/消极/中性评论的饼图),更重要的是,它为后续基于SnowNLP的深入分析——如情感随时间的变化趋势、不同产品属性下的情感差异、积极与消极评论的主题词提取与归因分析——提供了可靠的基础。数据处理的质量直接决定了情感分析洞察的深度与准确性,是整个项目中至关重要的一环。